[DL] BERT와 GPT로 배우는 자연어 처리 후기

총평

다양한 한국어 기반의 태스크에 대한 실습으로 NLP린이들이 쉽게 따라가며 감을 익힐 수 있는 서적

이론

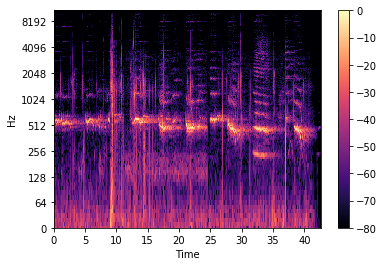

- 자칫 추상적인 개념에 빠져 이해하기 어려운 부분을 다양한 예시와 시각화로 초보자들도 이해하기 쉽게 설명해 놓았다.

- Transformer 논문을 먼저 보고나서 이 책을 접해서 그런지.. 용어가 한국어로 다 번역되어 있는 부분이 처음에 낯설었지만 몇번 보다보니 익숙해졌다.

실습

- GPU 리소스가 없는 독자를 위해 Colab에서 실행해볼 수 있도록 코드를 제공하고 있다.

HuggingFace의transformers라이브러리를 이용해 Trasnformer 기반 모델들을 쉽게 쉽게 실행해볼 수 있어서 좋은 듯하다.PyTorch Lightning을 이용한 간편한 학습과Flask를 이용한 웹 배포까지 실습해볼 수 있는 것이 인상 깊었다.

문서분류 실습 예시

RTX 3090이 달려있는 개인 Linux 서버에서 실습을 해보았는데, downstream task에 3 epoch 동안 fine-tuning하는데 약 30분정도 소요되었다. 확실히 Colab 보다 훨씬 빠른듯

배포 시에는 학교 내부망이어서 그런지 ngrok permission문제가 떴는데, 해결하지 못하였다. ㅠㅠ

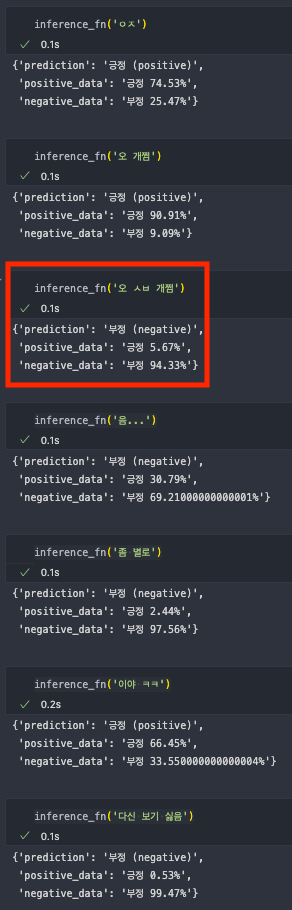

그래서 웹 배포는 안하고 jupyter notebook에서 임의의 단어를 넣어서 긍/부정 분류를 해보았다.

감성 분석 문서 분류 Task 예시

Upstream의 pre-trained model인 KcBERT 자체가 네이버 뉴스의 댓글 및 대댓글을 이용해 학습된 것이기 때문에 이것저것 신조어(?)를 넣어봤다.

대부분 잘 돌아가는데 욕설은 안먹히는듯 하다 ^^;;;;;

긴 문장을 실험해볼 걸 그랬지만 일단 짧은 문장 여러개 넣어보았는데 성능이 꽤 좋았다.

Leave a comment